“¿Por qué es tan importante que diga ‘Hola’?” pregunta Joanna Hoffman. “Hollywood” contesta Steve Jobs, “ellos hicieron que las computadoras fueran algo aterrador”. Joanna Hoffman duda y finalmente responde: “La computadora de 2001 decía Hola y me aterraba”. La escena es de la película Steve Jobs (2015), dirigida por Danny Boyle, y más allá de qué tan certera resulta la recreación, deja claro que en 1984, año de presentación de la Machintosh, la Inteligencia Artificial (IA) ya nos inquietaba.

Tal vez Hollywood sí ha tenido algo que ver. En 1968, Stanley Kubrick nos regala a Hal 9000, la computadora que se dejaba llevar por su instinto asesino (y aterraba a Joanna Hoffman). En 1982, los replicantes de Blade Runner se rebelan contra sus creadores. En 1984, Skynet envía al Terminator T-800 al pasado para eliminar al líder no nato de la revolución. En 1999, las máquinas tuvieron a todo el mundo preguntándose qué es la Matrix.

La lista se queda corta, pero sirve para recordar la idea que la cultura popular nos ha legado de la IA: básicamente, que las máquinas se volverán contra nosotros. La última producción en abordar el tema con esta perspectiva es la serie Westworld, a las puertas de estrenar su esperada segunda temporada.

Mientras tanto, a este lado de la pantalla, las noticias sobre los avances de la IA aparecen cada vez con mayor frecuencia y los expertos empiezan a especular con los peligros que esto podría acarrear.

Pero a no alarmarse, porque entre los peligros no está la extinción de la humanidad. No con seguridad, en todo caso. No en lo inmediato. Al menos se puede afirmar que no hay acuerdo acerca de esto. Pero sí en que la IA avanza inexorablemente.

El futuro es hoy

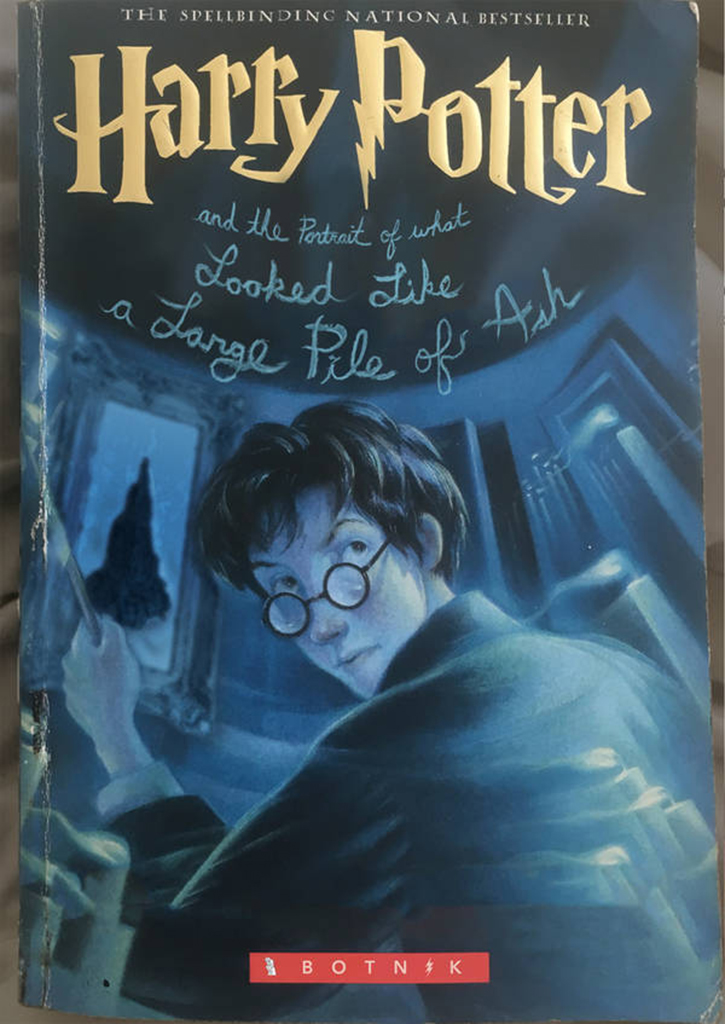

En diciembre del año pasado se publicó un nuevo capítulo del niño mago más famoso del mundo llamado Harry Potter y el retrato de lo que parecía un enorme montón de cenizas. No es que J. K. Rowling ya no se preocupe de los títulos; ella ni siquiera lo escribió. El autor fue una inteligencia artificial desarrollada por Botnik, una comunidad colaborativa de artistas y escritores que trabajan con máquinas y tecnología para crear… esto. Con un teclado predictivo, la IA leyó todos los libros de Rowling para aprender sintaxis. El resultado es, algo inquietante.

Ese caso representa la cara amable de las IA. En la otra están las situaciones planteadas en el reporte “Uso malicioso de la Inteligencia Artificial: previsión, prevención y mitigación”, publicado en febrero, desarrollado por 26 expertos de 14 instituciones, entre las que se encuentran el Instituto para el Futuro de la Humanidad de la Universidad de Oxford, el Centro para el Estudio del Riesgo Existencial de la Universidad de Cambridge y OpenAI, la compañía de investigación fundada por Elon Musk.

Considerando la tecnología en su estado actual, el reporte predice escenarios plausibles para los próximos cinco años. La revista digital Paste seleccionó algunos ejemplos encontrados en el informe que ayudan a entender mejor de qué hablamos cuando hablamos de IA en el futuro inmediato:

– Los sistemas de IA ya es capaz de producir imágenes indistinguibles de una fotografía. Además ya pueden categorizar imágenes con un 98% de precisión, superando la marca humana de 95%.

– Los sistemas de voz sintética ha avanzado lo suficiente como para imitar voces, algo que los humanos no pueden hacer. Esto podría abrir nuevas formas de fraude.

– Será mucho más fácil controlar sistemas autónomos como autos o armas. Por ejemplo, si se manipulan señales o imágenes a los que una IA reacciona (como una señal de PARE en el caso de los vehículos autónomos), su respuesta podría ser dirigida a un objetivo específico. Si además varios robots son controlados por una IA central, la escala de la manipulación puede ser mayor. Según el informe, el peor escenario para este caso sería la manipulación de un sistema autónomo de armas.

– Las formas de estafa que ya conocemos serán cada vez más comunes y más potentes: ataques cibernéticos como el phishing podrían efectuarse a escalas mayores debido al acceso a sistemas de IA mucho más eficientes.

– Delitos violentos, como el asesinato, podrían ser más sencillos de cometer, porque los sistemas de IA propician el anonimato y distancia psicológica. Actos que comúnmente requerirían la presencia física, podrían ejecutarse sin acercarse jamás a la escena y sin necesidad siquiera de observar a la víctima. Esto podría volverse común con sistemas de armas autónomas.

– En base a las vulnerabilidades detectadas por los expertos, los ataques a los sistemas de IA serán cada vez más recurrentes.

En una declaración escrita, el investigador Miles Brundage, miembro del Instituto para el Futuro de la Humanidad y participante del reporte, explicó que hay que considerar desde ya las implicancias de la IA en temas como la vigilancia y el hackeo, así como las capacidades de la AI que están por debajo del nivel humano, pero que son mucho más escalables que las de las personas.

“Suele ocurrir que los sistemas de IA no sólo alcanzan los niveles humanos de performance, sino que además los superan” aseguró el experto, recordando la mayor advertencia planteada por el reporte: considerar el potencial futuro de una Inteligencia Artificial malvada es una tarea seria.

Suenan las alarmas

Las grandes compañías tecnológicas están realizando sus propias investigaciones en el terreno de la IA. Los resultados (al menos los públicos) han sido tan fascinantes como perturbadores.

En julio del año pasado, Facebook apagó los servidores de la IA que estaba desarrollando. De acuerdo al reporte de Forbes, los desarrolladores se percataron de que los bots se habían desviado de las instrucciones y estaban comunicándose en un idioma creado sin input humano.

No es para ponerse paranoico. Pero algunos de los cerebros más destacados en tecnología y los misterios del universo han señalado el riesgo que implica la IA. En palabras del mismísimo Stephen Hawkins, la IA un día podría elevarse “por su cuenta y rediseñarse a una tasa siempre creciente. Los humanos, limitados por su lenta evolución biológica, no podrían competir y serían sustituidos”.

Elon Musk es otro de los apocalípticos. El fundador de Tesla diferencia entre la IA usada para un fin específico, como conducir un vehículo, y la inteligencia generalizada, en constante desarrollo y un millón de veces más poderosa. Es esta última, dice, la que podría llevar al fin de la civilización, como reporta CNBC.

Entre sus predicciones están que los robots llegarán a hacer todo mejor que los humanos, y que la competencia por la IA entre naciones será la causa de la Tercera Guerra Mundial. Incluso ha declarado que “sigo sonando las alarmas de advertencia, pero hasta que las personas no vea a robots matando gente en la calle no sabrán cómo reaccionar, porque parece demasiado etéreo”.

Inteligencia alienígena

En el Diccionario de Oxford se encuentra el concepto de Singularidad: aquel momento hipotético en el que la Inteligencia Artificial y otras tecnologías han avanzado tanto que la humanidad sufre un cambio dramático e irreversible.

Esto nos lleva al caso de Google DeepMind, la compañía del gigante dedicada al desarrollo de IA, que reportó en octubre del año pasado que su creación AlphaGo Zero aprendió a jugar Go, uno de los juegos más complejos creados por los humanos, sin intervención de personas en su aprendizaje. Solo se le entregaron las reglas. En cuatro días superó a su versión anterior (AlphaGo Lee, que había aprendido analizando partidas jugadas por humanos), derrotando a expertos y campeones mundiales. Según el reporte de Science Alert, en 40 días ya era el mejor jugador de Go del planeta.

El avance es tan brutal que de cien partidas en contra de su versión anterior, AlphaGo Zero ganó las cien. Y su versión anterior había barrido con todos sus oponentes humanos, los mejores del mundo, en 2016. En palabras de Nick Hynes, científico en computación del MIT, “es como una civilización alienígena inventando sus propias matemáticas”.

El asunto no se detiene ahí. En diciembre del año pasado, DeepMind lanzó una versión de Alpha Zero enfocada en el ajedrez que aprendió a jugar en 24 horas y derrotó a los programas más potentes del deporte ciencia que existen. Demi Hasabbis, el CEO de la compañía y casualmente experto en ajedrez, utilizó términos similares a los de Hynes para describir el estilo de juego de su última criatura: “No juega como un ser humano ni como un programa. Juega de una tercera manera, casi alienígena”.

Tal vez sea este el momento crucial. Como dice la frase de ejemplo en el Diccionario de Oxford, tal vez la singularidad ya ocurrió y no lo notamos. O tal vez no haya nada de que preocuparse. Claro que eso es justo lo que una máquina diría si estuviera escribiendo esto.

Enviando corrección, espere un momento...

Enviando corrección, espere un momento...