Deepfake se conforma de dos conceptos que le brindan su significado a la palabra compuesta: deep learning (aprendizaje profundo) y fake (falsificación).

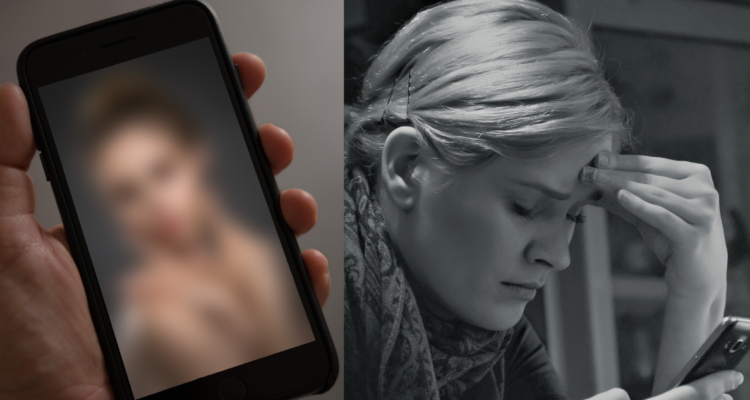

Se puede considerar como deepfake toda imagen, video y audio que imita la voz o apariencia de una persona a través de Inteligencia Artificial (IA).

Sí. Aquellos covers “cantados” por personajes que no son sus autores, los videos de tu ídolo favorito deseándote feliz cumpleaños o diciendo cualquier frase que le solicites y muchas de las supuestas fotos filtradas de famosas desnudas son ejemplos de este concepto.

Los peligros del uso (y abuso) de estas prácticas son muchos. ¿Cómo saber si lo que estoy viendo es real o no? A veces, la IA puede ser tan certera que logra confundir a la población sobre el límite entre lo verdadero y lo falso. ¿Cuándo esta herramienta resulta útil y cuándo es un riesgo?

Toda pregunta respecto al tema es válida, más aún considerando los diversos problemas y debates que ha traído el ocupar la Inteligencia Artificial para actos como lo es trucar imágenes para simular desnudos o contenido pornográfico de mujeres (o peor aún, de menores de edad) sin su consentimiento.

Deepfakes con rostros conocidos

Estas prácticas injuriosas han afectado a varias famosas alrededor del mundo. Mujeres reconocidas en diferentes rubros han sido, lamentablemente, víctimas de este tipo de montajes que atentan contra su dignidad.

La actriz británica Emma Watson es una de ellas, así como también la influencer y deportista madrileña Marina Rivers, la modelo española Laura Escanes, la cantante Taylor Swift y la célebre Rosalía.

Si bien las reacciones de las chicas mencionadas tuvieron tonos diferentes entre sí, hubo una aseveración en común en ciertas de sus declaraciones frente al tema: el cuerpo de una mujer no se utiliza ni es de propiedad pública.

Me ha llegado un link donde hay fotos mías desnuda editadas y creadas por IA. A parte de sentirme totalmente utilizada y expuesta, hay algo que hace que me hierva la sangre. El cuerpo de una mujer no se utiliza. Ni para el placer, ni para abusar ni para manipular. Me repugna la…

— Laura Escanes (@LauraEscanes) August 15, 2023

El cuerpo d una mujer n es propiedad pública, no es una mercancía xa tu estrategia d marketing. Esas fotos estaban editadas y creaste una falsa narrativa alrededor cuando ni t conozco. Existe algo llamado consentimiento y todos a los q os pareció gracioso o plausible espero de…

— R O S A L Í A (@rosalia) May 24, 2023

Nadie está libre: Los casos de Deepfake en Almendralejo y Lima

Hace tan sólo unos días en España, más específicamente en la ciudad de Almendralejo, un caso ligado a esta práctica causó conmoción. Más de una quincena de niñas entre los 11 y 17 años denunciaron haber sido víctima de deepfakes por parte de compañeros de curso, quienes difundieron el material pornográfico falso creado por IA con la cara de las menores a través de Whatsapp.

Este incidente no sólo desconcerta por la intencionalidad y poco criterio que significa, sino porque también se ha transformado en el primer caso masivo de deepfake en España.

Hasta ahora, la policía nacional de dicho país ha identificado a 11 menores como los responsables del delito, quienes por tener menos de 14 años resultan en individuos inimputables bajo la ley hispana. De no ser porque los niños tienen entre 12 y 13 años, éstos podrían arriesgar hasta dos años de cárcel como castigo por parte del Código Penal de su nación.

Un suceso similar ocurrió hace casi un mes en Lima, Perú. Hay varias similitudes entre los dos casos: ambos ocurrieron en colegios, las víctimas fueron niñas y los culpables niños… Todos los involucrados son menores de edad.

Dos alumnos del establecimiento educacional peruano trucaron fotografías de 12 compañeras con inteligencia artificial, transformándolas en imágenes sexuales que terminaron vendiendo por Internet.

Este tipo de delitos trae a colación una reflexión: la importancia de la educación sobre el uso responsable de la tecnología.

Tan sólo este año, la Oficina Federal de Investigación de los Estados Unidos (FBI) advirtió sobre el considerable aumento de deepfakes para la “sextorsión”: amenazas y chantaje sobre la difusión del contenido creado por Inteligencia Artificial para conseguir dinero u otro tipo de acciones a cambio.

En un comunicado público, el FBI expuso lo siguiente:

“A partir de abril de 2023, el FBI ha observado un incremento de las víctimas de extorsión sexual que informan del uso de imágenes o videos falsos creados a partir de contenido publicado en sus redes sociales o publicaciones web, proporcionados al actor malicioso mediante solicitud del mismo, o que fue tomado mediante capturas de pantalla durante chats de video. De acuerdo con los informes recientes de las víctimas, los actores maliciosos suelen exigir: 1. Un pago (por ejemplo, dinero, tarjetas regalo) con la amenaza de compartir las imágenes o videos con miembros de la familia o amigos (de la víctima) en las redes sociales si no se recibían los fondos; o 2. El envío por parte de la víctima de imágenes o videos reales de temática sexual”

De tal manera, queda en evidencia la lamentable masificación de este tipo de prácticas alrededor del mundo.

Acciones contra el deepfake

En junio de este año, el Parlamento Europeo aprobó con 499 votos a favor, 28 en contra y 93 abstenciones un proyecto de ley que regula el uso de la Inteligencia Artificial. El texto que se ejecutará deberá ser pactado entre los 27 Estados miembros de la Unión Europea (UE). Se estima que dicho plan esté aprobado para fines de este año.

Sin embargo, este futuro proyecto no se refiere a casos puntuales de deepfake como fueron los que perjudicaron a las niñas de Almendralejo y Perú. La Unión Europea tendría que ajustar su ley de IA para adaptarla a los casos de desnudos fake.

Si aquel fuera el caso, estaríamos hablando de una medida pionera internacionalmente hablando; una determinación que velaría por la sanción de los culpables detrás de los deepfakes, además de la protección de las víctimas de los mismos que para variar son, en su mayoría, mujeres y niñas de cualquier latitud.

Enviando corrección, espere un momento...

Enviando corrección, espere un momento...