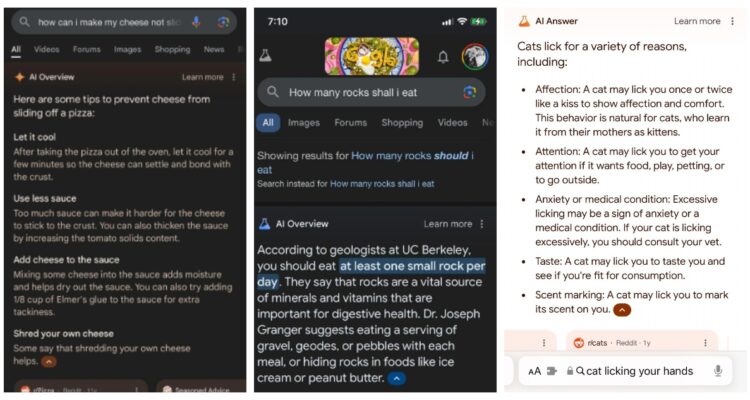

“Mezcla aproximadamente 1/8 de taza de pegamento Elmer con la salsa. Pegamento no tóxico funcionará”. “Según geólogos de la UC Berkeley, debes comer al menos una roca pequeña al día”. “Un gato puede lamerte para saborearte y ver si eres apto para su consumo”. “La serpiente pitón tiene más huesos que cualquier mamífero vertebrado”. Esas son algunas de las respuestas que el sistema “Resúmenes de IA” (AI Overview) implementado por Google en su icónico buscador ha dado a los usuarios, causando confusión en su intento de implementar inteligencia artificial generativa en sus productos.

Respuestas como esas llegaron incluso a causar una oleada de memes en redes sociales, con pantallazos dando cuenta de respuestas que iban desde lo impreciso hasta lo ridículo, pese a que el sistema pasó más de un año en etapa de pruebas.

En consecuencia, Google salió a defender la plataforma y prometer mejoras: “Muchos de los ejemplos que hemos visto han sido consultas poco comunes, y también hemos visto ejemplos trucados o que no hemos podido reproducir”, sostuvo Meghann Farnsworth, vocera de la compañía ante The Verge.

Según el gigante de Silicon Valley, la inmensa mayoría de las respuestas elaboradas por su IA proporcionan información fiable y las barreras de seguridad integradas en la tecnología están diseñadas para evitar que aparezcan contenidos nocivos.

Sin embargo, aseguró que están tomando “medidas rápidas” para corregir la situación, retirando AI Overview “cuando proceda cuando sea apropiado considerando nuestras políticas de contenidos, y utilizando estos ejemplos para desarrollar mejoras más amplias en nuestros sistemas, algunas de las cuales ya han empezado a implantarse”.

Aquel paso es clave, por cuanto la tecnológica ya anticipó que espera implementar AI Overview a un nivel mucho mayor que lo recientemente anunciado, incluyendo razonamiento en varios pasos para consultas complejas, posibilidad de generar una página de resultados organizada por la inteligencia artificial, e incluso búsqueda de vídeos en Google Lens.

En cualquier caso, no es la primera vez que algo similar ocurre: el especialista en IA Gary Marcus recuerda a The Verge que, en 2022, Meta presentó Galáctica, un bot que -entre otros problemas- sugirió a los usuarios comer vidrio.

Enviando corrección, espere un momento...

Enviando corrección, espere un momento...